¿Fallo judicial a través de ChatGPT?: Vocales utilizaron una inteligencia artificial en una audiencia

Ocurrió el pasado lunes en la Sala Constitucional Cuarta del Tribunal Departamental de Justicia de Santa Cruz en un caso contra tres periodistas

Tres periodistas fueron puestos ante un juez, acusados de violar la privacidad de una víctima de violencia. En este caso, no se consideró la Ley de Imprenta para procesar a los trabajadores de la prensa; además, denuncian que se utilizó una inteligencia artifical (AI) para decretar el fallo.

Ocurrió el pasado lunes en la Sala Constitucional Cuarta del Tribunal Departamental de Justicia de Santa Cruz, donde se presentó una Acción de Privacidad contra tres periodistas, que –según la denuncia– publicaron fotografías sin el consentimiento de una víctima de violación.

Se trata de de los periodistas independientes Marco Z., Ariel V. y Alberto R., denunciados por una mujer que decidió retractar su denuncia de violación contra un exfuncionario de Gobierno. Ella arguye que violaron su privacidad al publicar fotografías de sus lesiones, pese a que antes había dado el consentimiento para que se difundan, reporta Página Siete. Además, la publicación se hizo cubriendo partes de su cuerpo y sin dar el nombre del acusaso.

Los periodistas no solo denunciaron que no se haya tomado en cuenta la Ley de Imprenta, sino que también se haya emitido un fallo judicial a través de ChatGPT, una inteligencia artificial especializada en modelo de lenguaje que puede responder conversaciones.

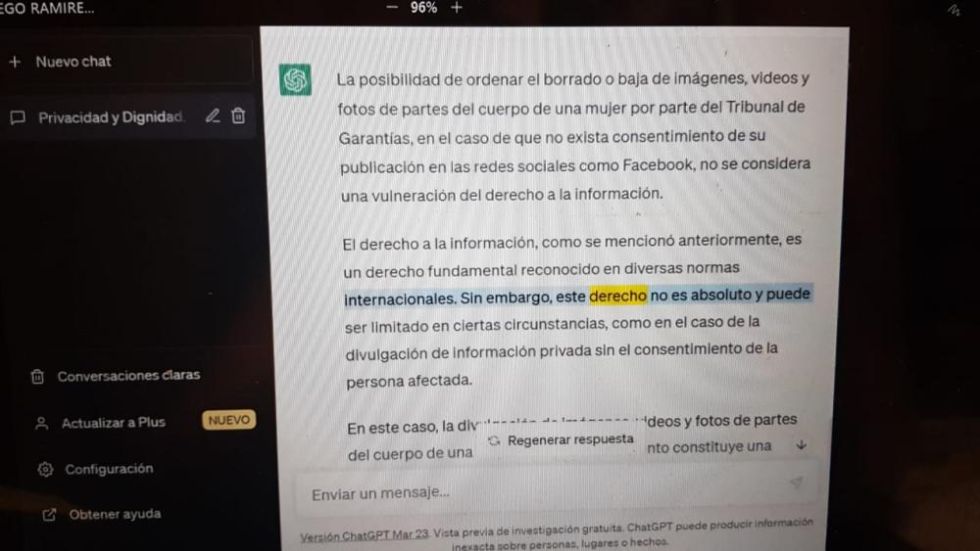

De acuerdo con la denuncia, los vocales de la Sala Constitucional Cuarta del Tribunal Departamental de Justicia de Santa Cruz, Jimmy López y Diego Ramírez, pusieron una computadora para que el ChatGPT responda.

“Nos sorprendimos nosotros porque no era la Ley de Imprenta, pensamos que los vocales lo iban a rechazar, pero no solo no rechazaron, sino que jugaron consultando a la inteligencia artificial”, expresó Marco Z., en una entrevista con Página Siete.

Detalló que las consultas a la inteligencia artificial ocurrieron luego de un cuarto intermedio y cuando los vocales deberían liberar. Y así fue que determinaron las sanciones, calificando este hecho como “histórico”.

“Volvieron y dijeron que iban hacer algo que nunca se vio en la justicia boliviana, que iban a hacer historia consultándole a la inteligencia artificial cuales son las sanciones que nos tienen que dar y pusieron una computadora, donde un robot responde, como preguntándole a Google, cuál es la sanción que tienen que dar, y mediante eso nos sancionaron. Nos quedamos asombrados, pensábamos que era una broma lo que estaba pasando”, relató el periodista.

En las capturas de la audiencia de los periodistas, difundidas por Página Siete se observa, como el ChatGPT define que “la divulgación de fotos de partes del cuerpo de una mujer en las redes sociales, por los medios de prensa y sin su consentimiento o autorización, es una violación de la privacidad y la dignidad de la persona”.

“Es posible que el Tribunal de Garantías ordene el borrado o baja de estas imágenes para proteger los derechos fundamentales de la mujer afectada. Es importante tener en cuenta que la eliminación de estas imágenes no implica una censura o una restricción injustificada del derecho a la información. El Tribunal de Garantías debe evaluar cuidadosamente las circunstancias del caso y equilibrar los derechos en juego, y si se concluye que la eliminación de las imágenes es necesaria para proteger los derechos de la mujer afectada, entones esta medida sería justificada y proporcionada”, señala ChatGPT.

Finalmente, los vocales ordenaron eliminar las fotografías publicadas por los periodistas, quienes –según su abogada– accedieron a cumplir esta disposición.

Denuncian que direccionaron las preguntas

La abogada de la Asociación de Periodistas, Raquel Guerrero, observó que las consultas realizadas al ChatGPT fueron direccionadas, lo cual condicionó las respuestas.

Señaló que, en las consultas a la inteligencia artificial, no se tomó en cuenta que la misma mujer había consentido y solicitado la publicación de las fotografías, además que los periodistas tuvieron el cuidado de poner sólo las imágenes de las lesiones y no así evidenciar la identidad de la víctima.

Si bien el uso de la inteligencia artificial no está contemplado en el procedimiento constitucional, en criterio de la abogada Guerrero, la utilización de la inteligencia artificial tiene sus aspectos positivos como negativos.

Indicó que se sería positivo utilizar la inteligencia artificial como “apoyo” de consulta para jueces y abogados, al igual que se podría utilizar el Google, sin embargo, considera que en este caso las preguntas fueron direccionadas.

La jurista tildó errónea la decisión del Tribunal, tomando en cuenta que se difundieron a pedido de la víctima, existió una denuncia de violencia, entre otros aspectos. De todas maneras, anunció que los periodistas cumplirán la decisión de borrar las fotografías.

Recomendación del ChatGPT

Ante este caso, Erbol realizó una consulta al ChatGPT si se puede usar como fundamento para resoluciones judiciales y esta fue la respuesta:

No, el ChatGPT no puede ser utilizado como fundamento para resoluciones judiciales. Aunque el ChatGPT es una herramienta útil para responder preguntas y proporcionar información, no es un sustituto de la experiencia humana, la comprensión jurídica y el análisis crítico.

Las resoluciones judiciales se basan en la interpretación de la ley, los hechos del caso y la aplicación de la jurisprudencia y la doctrina relevante. Estas decisiones requieren un análisis complejo que implica la consideración de muchos factores y la aplicación de la lógica, el razonamiento y el conocimiento jurídico.

El ChatGPT no tiene la capacidad de tomar en cuenta todos los aspectos relevantes de un caso y, por lo tanto, no puede proporcionar una opinión legal precisa. Por lo tanto, se debe confiar en la experiencia y el conocimiento de los abogados, jueces y otros profesionales del derecho para tomar decisiones judiciales fundamentadas.